Les géants du web font les yeux doux aux producteurs de contenu, médias en tête. Des sirènes pas tout à fait nouvelles, à l’échelle du web, mais auxquelles les éditeurs ne savent pas toujours si ils doivent céder ou non. Histoire et perspectives (comme on dit).

Tout commence avec les flux RSS. On retient de RSS qu’il veut dire Really Simple Syndication. C’est son sens à partir de 2002. On parlait de Rich Site Summary dès 1999. Il s’agissait avec les flux RSS “d’éviter de vous abonner aux myriades de newsletters qui surchargent votre messagerie tout en restant informé des mises à jour” des sites. La technologie est popularisée en France par les blogs dans les années 2000. Le format a évolué, a des concurrents, comme Atom, mais le principe reste le même.

Tout commence avec les flux RSS. On retient de RSS qu’il veut dire Really Simple Syndication. C’est son sens à partir de 2002. On parlait de Rich Site Summary dès 1999. Il s’agissait avec les flux RSS “d’éviter de vous abonner aux myriades de newsletters qui surchargent votre messagerie tout en restant informé des mises à jour” des sites. La technologie est popularisée en France par les blogs dans les années 2000. Le format a évolué, a des concurrents, comme Atom, mais le principe reste le même.

Concrètement, on copie une adresse web, celle du flux, et on la colle dans son agrégateur, là où on lira les mises à jour apportées par l’ensemble des flux auxquels on est abonné. Plus besoin de parcourir les sites, ou d’attendre les newsletters pour connaître les dernières nouvelles.

Côté presse, L’Humanité semble être le premier à s’y être mis, puis Le Monde diplomatique. Libération propose un flux RSS en 2003. On commence à s’abonner aux blogs, aux sites de presse.

Le plus populaire des agrégateurs, service dans lequel on a pu lire les flux RSS et Atom a sans conteste été Google reader. Ouvert le 7 octobre 2005 et passe en version stable le 17 septembre 2007. L’outil propose une interface proche de celle de Gmail. Un vrai confort pour l’utilisateur habitué à sa boîte mail qui n’a pas à apprendre l’utilisation d’un nouvel outil pour se repérer dans ses flux. En 2013, il est un des agrégateurs web les plus populaires. Le 13 mars 2013, Google annonce la fermeture du service le 1er juillet 2013, dans le cadre d’une politique de nettoyage de leurs services.

Le plus populaire des agrégateurs, service dans lequel on a pu lire les flux RSS et Atom a sans conteste été Google reader. Ouvert le 7 octobre 2005 et passe en version stable le 17 septembre 2007. L’outil propose une interface proche de celle de Gmail. Un vrai confort pour l’utilisateur habitué à sa boîte mail qui n’a pas à apprendre l’utilisation d’un nouvel outil pour se repérer dans ses flux. En 2013, il est un des agrégateurs web les plus populaires. Le 13 mars 2013, Google annonce la fermeture du service le 1er juillet 2013, dans le cadre d’une politique de nettoyage de leurs services.

Les utilisateurs passent alors à Feedly, reviennent à Netvibes, se tournent depuis peu vers Inoreader.

Google Alertes, le service d’alertes de Google actualités permet toujours de s’abonner à un flux RSS qui reprend les derniers articles parus correspondant à une requête donnée. Je peux par exemple recevoir automatiquement les derniers articles publiés contenant le mot Rouen directement dans mon agrégateur. Le flux RSS est le fondement, depuis, de tout dispositif de veille digne de ce nom.

Google Alertes, le service d’alertes de Google actualités permet toujours de s’abonner à un flux RSS qui reprend les derniers articles parus correspondant à une requête donnée. Je peux par exemple recevoir automatiquement les derniers articles publiés contenant le mot Rouen directement dans mon agrégateur. Le flux RSS est le fondement, depuis, de tout dispositif de veille digne de ce nom.

Le succès des flux RSS tient à la normalisation du format, et au fait qu’on peut les afficher n’importe où. Je peux mixer des flux, les filtrer, afficher le résultat sur un site. C’est une vraie ouverture sur un travail automatisé de publication d’un site sur l’autre. Et, c’est réellement simple, même sans connaissances informatiques, avec une foultitudes d’outils qui permet de multiples applications.

Lorsque j’arrive en octobre 2008 à Paris-Normandie, avec pour mission de faire ce qu’il fallait pour amener le journal à une présence digne de ce nom sur le web, j’ai demandé qu’un flux RSS des articles soit disponible le plus rapidement. J’ai dû le faire dès ma première réunion avec les responsables informatiques du site. C’était alors une condition indispensable à la visibilité de l’information produite en ligne.

Déjà, cependant, deux écoles s’affrontaient. Pour la première, il convenait que les articles contiennent la version intégrales des articles, que cette version complète soit lisible directement dans les agrégateurs. Le plus important étant que l’information circule, et cela facilitait la vie des internautes qui n’avaient pas à cliquer pour aller lire la version complète sur le site d’origine de l’information. Pour la seconde, un extrait, généralement le début de l’article, suffisait : les internautes qui étaient intéressés n’avaient qu’à cliquer pour se rendre sur la version complète, sur le site initial. Pour les uns, le flux RSS servait à diffuser l’information, pour les autres, il avait pour mission de recruter des lecteurs. Internet oblige, on allait déjà jusqu’à insulter celui qui tronquait son flux et refusait de ce fait la libre circulation de l’information. Mais ?, répondait-il déjà… Je vis en vendant de la publicité sur mon site, il faut bien que les internautes y viennent, sinon, je n’ai qu’à mettre la clef sous la porte. Le dilemme n’est pas tout à fait d’hier.

Même combat contre un qui pratique l’externalisation du contenu à grande échelle : Google Actualités. Le service est créé en avril 2002. C’est un moteur de recherche spécialisé dans l’actu. Plus de 500 sources francophones (2500 anglophones) sont passées au cribles, moulinées, et proposées aux internautes.

Même combat contre un qui pratique l’externalisation du contenu à grande échelle : Google Actualités. Le service est créé en avril 2002. C’est un moteur de recherche spécialisé dans l’actu. Plus de 500 sources francophones (2500 anglophones) sont passées au cribles, moulinées, et proposées aux internautes.

Les relations entretenues depuis entre Google actu et les médias sont plutôt tendues.

En mars 2005, l’Agence France-Presse décide d’attaquer Google en justice au sujet de Google Actualités. L’agence de presse accusait Google d’avoir enfreint le copyright sur ses dépêches et ses photos, en les diffusant sans son autorisation. L’AFP lui réclame 17,5 millions de dollars de dommages et d’intérêts. Avant le terme de cette affaire, Google a pris la décision de retirer de son site tout le contenu AFP et de ne plus l’indexer dorénavant. Un accord est trouvé en 2007.

Je me souviens d’une réunion un peu tendue à Paris-Normandie en 2009 ou 2010. Le PDG avait dans l’idée de demander à Google de retirer le journal de Google Actualité. Pour lui, comme pour beaucoup d’autres, les internautes se satisfaisant des quelques lignes proposées par Google, ne venaient plus sur le site. Et le bénéfice d’audience qu’on retirait de Google Actualités n’était pas compensé par ces pertes. J’avais du batailler pour démontrer que l’on était en phase de conquête d’audience et que si l’on sortait de Google Actu, on perdrait alors 15% de nos visiteurs. Une hypothèse qui me permit alors de convaincre de rester indexé.

En Belgique, en 2011, le choix n’est pas le même. Après plusieurs années de procès contre Google, la société de gestion de droits des éditeurs de presse quotidienne francophone et germanophone Copiepresse voit l’ensemble des contenus en ligne des sites qu’elle représente (LeSoir, La Libre Belgique, La Dernière Heure, Sudpresse, l’Avenir) retirés de l’index de Google Actualités. Cet événement intervient suite à un premier jugement de la cour de Bruxelles en 2006, qui ordonnait le retrait de nombreux titres de la presse belge du site car publiés sans autorisation sous peine d’une amende d’un million d’euros par jour de retard en cas d’inexécution, ainsi que l’affichage sur la page d’accueil de Google.be et News.google.be de la décision de référé durant cinq jours (avec astreinte de 500 000 euros par jour de retard). Après une réduction de l’astreinte à 25 000 € par jour de retard en février 2007 et un appel de Google en juillet de la même année, le groupe a décidé, « compte tenu de la récente décision d’appel (…) [de retirer] les contenus de Copiepresse » de son index et déclare : « Nous regrettons d’avoir à prendre une telle mesure et nous restons ouverts à travailler en collaboration avec les membres de Copiepresse à l’avenir ».

En octobre 2012, 154 quotidiens de la presse brésilienne prennent la décision de se désindexer de Google Actualités. Ces quotidiens jugent qu’il n’est pas rentable d’être présent sur Google Actualités et que les quelques lignes affichées sur le service de Google n’incitent pas l’internaute à ensuite visiter leurs sites.

En 2013 en France, Google a trouvé un accord avec l’État qui a conduit à la création d’un fond de 60 millions d’euros pour aider la presse française à innover dans le numérique.

En 2014, Google actualités disparait d’Espagne suite à une loi obligeant les agrégateurs de contenu à payer une contribution aux éditeurs de presse pour la diffusion de leur production. En Allemagne suite à une une loi similaire Google a retiré les images et description des article sur Google Actualité. Pour que ces contenus soient diffusés, les éditeurs doivent accepter de ne pas réclamer les compensations fixées par la loi.

En 2015, le fonds Google pour la presse initié en France deux ans plus tôt devient européen. Google finance l’innovation, et les relations, on s’en doute, devraient se pacifier entre la multinationale et les éditeurs.

Entre temps, les choses ont bien changé. La période de la suprématie des blogs a laissé place à celles des réseaux sociaux. Et l’ordinateur cède le pas, petit à petit, au mobile et à la tablette.

Les contenus sont partagés sur les réseaux sociaux. Facebook et Twitter en tête. On retrouve sur Facebook les mêmes éléments que sur Google Actualités, les possibilités de commentaire en plus. C’est la conversation qui sort des sites pour se diffuser ailleurs. Et, petit à petit, la stratégie sociale laisse imaginer qu’on va pouvoir échapper à l’hégémonie de Google. En 2014, 20% des internautes qui visitent des sites d’informations proviennent de Facebook.

Facebook va multiplier les fonctionnalités favorisant l’émergence de contenu sur son réseau. On peut évidemment automatiser la publication de flux RSS sur ses pages. On peut, et on le sait moins, publier des articles complets, mis en forme, illustrés, sur les pages dans un onglet prévu à cet effet (l’onglet articles). On peut, enfin, intégrer ses vidéos directement sur Facebook sans avoir besoin de passer par un hébergeur externe comme Youtube et Dailymotion. Une voie que suivra Twitter.

Facebook va multiplier les fonctionnalités favorisant l’émergence de contenu sur son réseau. On peut évidemment automatiser la publication de flux RSS sur ses pages. On peut, et on le sait moins, publier des articles complets, mis en forme, illustrés, sur les pages dans un onglet prévu à cet effet (l’onglet articles). On peut, enfin, intégrer ses vidéos directement sur Facebook sans avoir besoin de passer par un hébergeur externe comme Youtube et Dailymotion. Une voie que suivra Twitter.

La bataille pour héberger les vidéos n’est pas nouvelle. Sur ce contenu particulier, chacun a cherché sa voie. La presse a expérimenté des solutions propriétaires, signé des accords avec Dailymotion ou avec Youtube. Ce contenu particulier, qui demande des ressources conséquentes en matière d’hébergement et de bande passante, a poussé à trouver des solutions techniques spécifiques. C’est Youtube, propriété de Google, qui a largement emporté la mise. 300 heures de vidéo sont mises en ligne chaque minute sur YouTube. Le nombre d’heures de visionnage mensuelles sur YouTube augmente de 50 % chaque année. Une mise d’autant plus intéressante que la publicité vendue en amont des vidéos est plus rémunératrice que les autres formats proposés en display sur le web.

En hébergeant leurs vidéos sur Youtube ou Dailymotion, et maintenant Facebook, ou Twitter, les médias ont fait de premiers pas, parfois assez tôt, dans l’externalisation de leur contenu. Ces vidéos que l’on pouvait voir ailleurs que chez eux, et qui, d’ailleurs, touchent souvent plus de monde à l’extérieur de leurs pages web que sur elles-mêmes.

Les nouveaux acteurs n’y voient pas particulièrement d’inconvénients. Bien au contraire. Youtube, déjà, admet que les vidéos que le service héberge sont plus vues sur des sites tiers que son site lui-même. Le modèle de Youtube a donné naissance à une nouvelle génération de médias, sur un modèle disruptif : les youtubeurs. On les compare souvent aux blogueurs du milieu des années 2000. Mais leur influence est semble-t-il bien supérieur. Avant même d’occuper le devant de la scène médiatique, Enjoyphoenix avait plus d’influence sur les réseaux sociaux que la presse féminine, Elle ou Marie-Claire. Si tout a démarré avec sa chaîne Youtube, la jeune femme est passée à la télévision, a publié un livre, et génère aujourd’hui plusieurs centaines de milliers d’euros de chiffre d’affaires annuels. Sur un créneau qui avait jusque là vocation à être occupé par la presse jeune féminine. Le contenu produit par Marie, puisque c’est son prénom, n’était pas sur un site, pas sur un blog, c’était au départ des vidéos sur Youtube. On peut considérer qu’elle est devenu un média. Ils sont nombreux dans ce cas à traiter de l’information, sur une niche, sans se poser la question de qui héberge leur contenu, mais en trouvant néanmoins un modèle économique. Il y en a qui parlent de jeu vidéo, comme le rouennais MrleV12, d’autres de livres… C’est le nouvel eldorado de la diffusion de l’information. Et Youtube a eu la bonne idée de promouvoir le partage de revenu, qui motive ses utilisateurs à se créer une audience sur leur site. Aucun média historique à notre connaissance n’est arrivé à un résultat comparable à ceux de ces youtubeurs amateurs devenus professionnels. Sans parler de ceux, tels Norman ou Cyprien qui se sont spécialisés dans l’humour plutôt que l’information.

Les nouveaux acteurs n’y voient pas particulièrement d’inconvénients. Bien au contraire. Youtube, déjà, admet que les vidéos que le service héberge sont plus vues sur des sites tiers que son site lui-même. Le modèle de Youtube a donné naissance à une nouvelle génération de médias, sur un modèle disruptif : les youtubeurs. On les compare souvent aux blogueurs du milieu des années 2000. Mais leur influence est semble-t-il bien supérieur. Avant même d’occuper le devant de la scène médiatique, Enjoyphoenix avait plus d’influence sur les réseaux sociaux que la presse féminine, Elle ou Marie-Claire. Si tout a démarré avec sa chaîne Youtube, la jeune femme est passée à la télévision, a publié un livre, et génère aujourd’hui plusieurs centaines de milliers d’euros de chiffre d’affaires annuels. Sur un créneau qui avait jusque là vocation à être occupé par la presse jeune féminine. Le contenu produit par Marie, puisque c’est son prénom, n’était pas sur un site, pas sur un blog, c’était au départ des vidéos sur Youtube. On peut considérer qu’elle est devenu un média. Ils sont nombreux dans ce cas à traiter de l’information, sur une niche, sans se poser la question de qui héberge leur contenu, mais en trouvant néanmoins un modèle économique. Il y en a qui parlent de jeu vidéo, comme le rouennais MrleV12, d’autres de livres… C’est le nouvel eldorado de la diffusion de l’information. Et Youtube a eu la bonne idée de promouvoir le partage de revenu, qui motive ses utilisateurs à se créer une audience sur leur site. Aucun média historique à notre connaissance n’est arrivé à un résultat comparable à ceux de ces youtubeurs amateurs devenus professionnels. Sans parler de ceux, tels Norman ou Cyprien qui se sont spécialisés dans l’humour plutôt que l’information.

Bref, la question devient pour les médias : où faut-il donner l’information ? Jusqu’où un site est-il indispensable ? Peut-on faire autrement ? Doit-on céder aux sirènes des réseaux sociaux qui proposent d’héberger chez eux les contenus que nous produisions jusque là chez nous même si d’aucun les lisaient ailleurs.

En 2011, j’ai lancé Grand-Rouen.com. Le projet a pris l’allure d’un site d’information locale. Mais au cours de la réflexion sur le projet, d’autres solutions ont été sinon sérieusement envisagées, du moins évoquées avec sérieux. L’une d’entre elles consistait à ne pas avoir de site. C’est, rendons à César ce qui lui appartient, Nicolas Voisin, alors patron d’Owni qui a évoqué le premier cette idée dans son bureau proche de République, à Paris. Il s’agissait d’envisager quelque chose qui change, radicalement. Il me proposait même très sympathiquement de m’accompagner si je suivais cette voie. Je n’ai pas eu le cran. Je ne voyais pas quel modèle économique trouver, alors. Et je me voyais mal pieds et poings liés avec une entreprise dont les choix stratégiques m’échappaient totalement et dont je dépendrais absolument. Je ne sais pas si j’ai eu raison de ne pas pousser dans cette direction, de ne pas oser. Mais force est de constater aujourd’hui qu’on n’a pas besoin d’un support technique, un site, ou une appli, pour lancer un média. On peut le faire avec les outils existant en ligne, le plus important étant de construire une communauté autour de son projet éditorial, communauté qui se retrouvera quel que soit le support, et qui même suivra le média de support en support, le cas échéant.

En 2011, j’ai lancé Grand-Rouen.com. Le projet a pris l’allure d’un site d’information locale. Mais au cours de la réflexion sur le projet, d’autres solutions ont été sinon sérieusement envisagées, du moins évoquées avec sérieux. L’une d’entre elles consistait à ne pas avoir de site. C’est, rendons à César ce qui lui appartient, Nicolas Voisin, alors patron d’Owni qui a évoqué le premier cette idée dans son bureau proche de République, à Paris. Il s’agissait d’envisager quelque chose qui change, radicalement. Il me proposait même très sympathiquement de m’accompagner si je suivais cette voie. Je n’ai pas eu le cran. Je ne voyais pas quel modèle économique trouver, alors. Et je me voyais mal pieds et poings liés avec une entreprise dont les choix stratégiques m’échappaient totalement et dont je dépendrais absolument. Je ne sais pas si j’ai eu raison de ne pas pousser dans cette direction, de ne pas oser. Mais force est de constater aujourd’hui qu’on n’a pas besoin d’un support technique, un site, ou une appli, pour lancer un média. On peut le faire avec les outils existant en ligne, le plus important étant de construire une communauté autour de son projet éditorial, communauté qui se retrouvera quel que soit le support, et qui même suivra le média de support en support, le cas échéant.

Facebook a commencé à convaincre les médias d’héberger directement les vidéos sur sa plateforme. Le moyen est simple : une vidéo partagée directement sur Facebook est plus visible qu’une vidéo Youtube partagée sur Facebook. Dans la foulée, ou presque, Facebook a commencé à proposer les “Instant Articles”. Un format d’article enrichi d’interactivité potentielle à disposition des médias pour qu’ils racontent directement leurs histoires, leurs histoire en entier, sur le réseau social. Plus besoin de se rendre sur le site du New York Times pour le lire : l’article est intégralement disponible sur mon mobile, sans que j’ai à quitter Facebook.

Facebook a commencé à convaincre les médias d’héberger directement les vidéos sur sa plateforme. Le moyen est simple : une vidéo partagée directement sur Facebook est plus visible qu’une vidéo Youtube partagée sur Facebook. Dans la foulée, ou presque, Facebook a commencé à proposer les “Instant Articles”. Un format d’article enrichi d’interactivité potentielle à disposition des médias pour qu’ils racontent directement leurs histoires, leurs histoire en entier, sur le réseau social. Plus besoin de se rendre sur le site du New York Times pour le lire : l’article est intégralement disponible sur mon mobile, sans que j’ai à quitter Facebook.

De quoi conforter encore plus ceux qui n’imaginent même plus qu’ils sont sur Internet lorsqu’ils utilisent Facebook. Et il y en a.

Facebook n’est pas le seul à promouvoir l’idée que les contenus sont mieux chez eux qu’ailleurs. Snapchat, qui permet aux jeunes, surtout aux jeunes, d’échanger des messages qui disparaissent aussitôt lus, proposent dans un onglet, Discover, des “stories” alimentées par de grands médias américains. Même le service de streaming audio Spotify s’intéresse aux vidéos d’actualités. Et Apple annonce la création de « News », un nouveau service consacré à l’info. News est une application dédiée qui sera installée par défaut sur chaque appareil Apple, avec l’iOS 9. Elle regroupera le contenu d’éditeurs partenaires qui proposeront leurs articles dans un format multimédia optimisé pour les supports mobiles. Très près de Facebook, quoi.

Facebook n’est pas le seul à promouvoir l’idée que les contenus sont mieux chez eux qu’ailleurs. Snapchat, qui permet aux jeunes, surtout aux jeunes, d’échanger des messages qui disparaissent aussitôt lus, proposent dans un onglet, Discover, des “stories” alimentées par de grands médias américains. Même le service de streaming audio Spotify s’intéresse aux vidéos d’actualités. Et Apple annonce la création de « News », un nouveau service consacré à l’info. News est une application dédiée qui sera installée par défaut sur chaque appareil Apple, avec l’iOS 9. Elle regroupera le contenu d’éditeurs partenaires qui proposeront leurs articles dans un format multimédia optimisé pour les supports mobiles. Très près de Facebook, quoi.

Twitter n’est pas en reste, avec le projet « Twitter Lightning » qui devrait consister à embaucher des journalistes pour trier et organiser son contenu afin d’offrir un meilleur accès à l’information autour des thématiques du moment. Et pendant ce temps, Instagram change les modalités de recherche pour concurrencer Twitter sur le temps réel…

Facebook laisserait jusqu’à 100% de la publicité générée par ces articles aux éditeurs, à condition qu’ils vendent eux-mêmes l’espace. 60% si la publicité est vendue par le réseau social. De quoi appâter le chaland. Au début tout du moins. Car les observateurs ne manquent pas de relever qu’une fois en position de force, ces distributeurs d’un nouveau genre auront toute latitude pour modifier la visibilité des contenu, ou les tarifs proposés. Facebook a déjà joué à ce jeu là, baissant petit à petit la visibilité organique des publications sur les pages, et proposant parallèlement de payer pour être plus vu. Ce ne serait donc pas une première.

L’inquiétude économique n’est pas la seule qui mine les éditeurs confrontés à la question d’y aller ou pas. S’y ajoute une interrogation éditoriale. Le choix des canaux de diffusion n’est pas sans incidence sur le choix des sujets traités, ni sur la façon de les traiter. L’algorithme de Google a modifié l’écriture de ceux qui visent les premières places dans les résultats du moteur de recherche. L’algorithme de Facebook, le edgerank, a jusque là privilégié les sujets à forte charge émotionnelle, au détriment des traitements plus sérieux. Facebook a annoncé en juin 2015 que son algorithme prendrait dorénavant en compte non seulement le nombre de “J’aime”, de partage ou de commentaires, mais aussi le temps passé par l’internaute sur chaque publication pour choisir ce qu’il lui présentera à l’avenir. Une nouvelle qui laisse espérer plus de place aux sujets “sérieux”, qu’on lit sans nécessairement ressentir le besoin d’en faire étalage ou de les commenter.

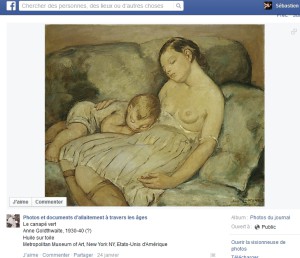

Et quid est de la censure ? Facebook a quelques soucis avec la nudité. Des photos d’allaitement comme des tableaux classiques y ont été allègrement censuré. Parfois, Facebook est revenu sur ses décisions. D’autres fois non. Les médias peuvent-ils laisser à des algorithmes, ou des industriels, extérieurs à leur rédaction le soin non seulement de hiérarchiser l’information, mais en outre de choisir quels sujets peuvent être traités ou pas ? Cette interrogation est loin d’être neutre.

Et quid est de la censure ? Facebook a quelques soucis avec la nudité. Des photos d’allaitement comme des tableaux classiques y ont été allègrement censuré. Parfois, Facebook est revenu sur ses décisions. D’autres fois non. Les médias peuvent-ils laisser à des algorithmes, ou des industriels, extérieurs à leur rédaction le soin non seulement de hiérarchiser l’information, mais en outre de choisir quels sujets peuvent être traités ou pas ? Cette interrogation est loin d’être neutre.

S’opposeront encore longtemps, on peut le parier ceux qui laissaient filer leurs articles entier dans les flux RSS parce qu’ils faisaient le pari qu’en allant là où le lecteur allait ils ne perdraient pas le contact avec lui, et ceux qui feront toujours tout pour le retenir chez eux, espérant leur lien assez fort pour qu’il reste solide. Et bien malin qui pourra prédire lesquels auront raison et lesquels auront tort. Les plus pragmatiques essaieront, au risque de se tromper, les solutions qui se présentent, sans prendre le risque de brûler leurs vaisseaux. Encore, et encore, puisque c’est ainsi qu’on avance depuis vingt ans sur le web.

Pour autant, il convient de mettre en place les moyens de mesurer l’impact des tests, de quantifier le succès ou l’échec. Facebook offre aujourd’hui des outils de ciblage et de mesures inouïs sur d’autres supports, et l’on a avec les statistiques de différents services en lignes des outils qui permettent des retours d’expérience objectivés, rapides, et précis. Autant d’éléments dont il convient d’apprendre à se servir pour aider à la diffusion, et faire les bons choix.

Ce texte correspond au contenu d’une masterclass donnée dans le cadre de la Medialabsession de Rouen, le 27 juin 2015.

Quelques sources :

- Ariane et le Web : qu’est-ce que le RSS ou la syndication de contenu ? Véronique Ginouvès https://aldebaran.revues.org/70

- Article Google Actualités de Wikipedia https://fr.wikipedia.org/wiki/Google_Actualit%C3%A9s

- Les Youtubeuses pèsent plus lourd sur Internet que la presse féminine http://www.mediacademie.org/1649/les-youtubeuses-pesent-plus-lourd-sur-internet-que-la-presse-feminine

- News, quand Apple joue l’information à guichet fermé http://www.mediacademie.org/2173/news-quand-apple-joue-linfo-a-guichet-ferme

- L’externalisation des articles, une solution viable ? http://www.mediacademie.org/2127/lexternalisation-des-articles-une-solution-viable

Bonjour,

Très intéressant, merci.

Mais que pensez-vous de la valeur du contenu, lui même, et/ou du réseau humain qui l’écrit ou le lit ?

Car, si l’on prend tous les exemples que vous donnez, tout se passe dans un contexte où c’est la publicité qui paie. Ainsi, au sujet des youtubers, s’ils ont du succès ils se font embaucher par le parisien et les journaux féminins, d’accord, ils publient des « instants articles » ou assimilés, mais google, facebook, tous les journaux, etc, n’ont pas d’autre modèle économique que la publicité. C’est donc la publicité qui donne de la valeur à tout ça.

Imaginons maintenant, par exercice de pensée, que la publicité n’existe pas. Et vous pouvez très bien me répondre qu’elle n’existe pratiquement pas sur youtube, c’est vrai. (ou alors j’ai des adblock efficaces, je ne sais pas).

Comment, par quel moyen, quels sont les outils, pour qu’un contenu, pour qu’une communauté (enfin, de ce qu’on appelle « communauté » sur le web) ait une valeur ?

Merci.